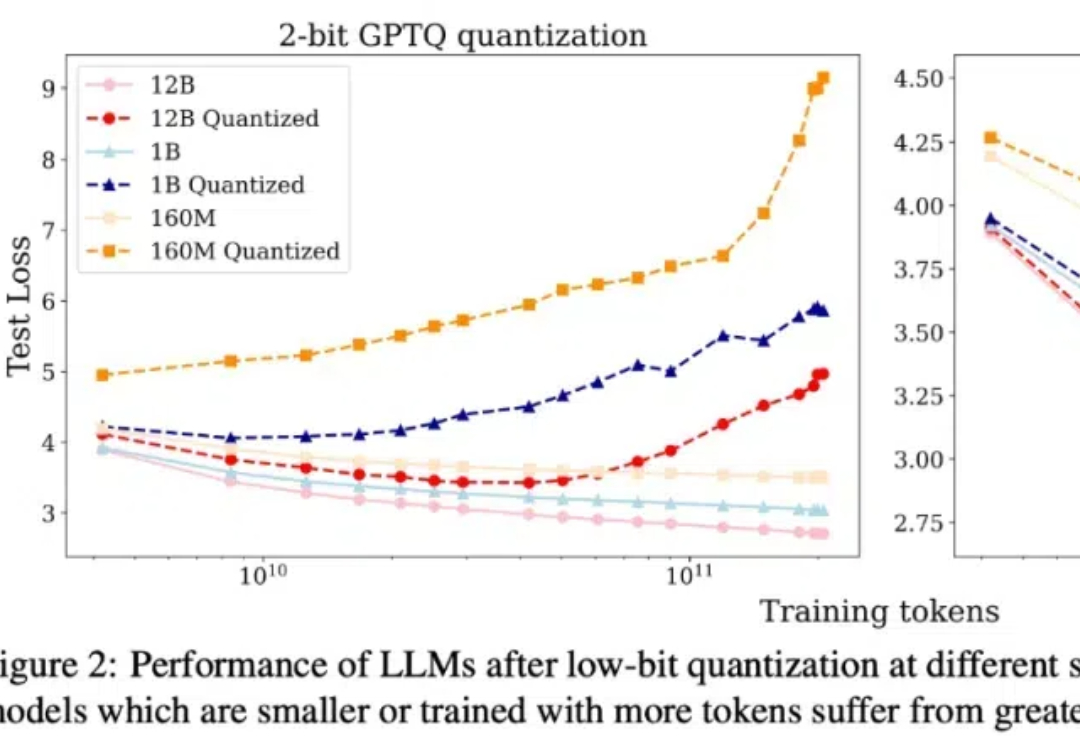

低精度只适用于未充分训练的LLM?腾讯提出LLM量化的scaling laws

低精度只适用于未充分训练的LLM?腾讯提出LLM量化的scaling laws本文介绍了一套针对于低比特量化的 scaling laws。

本文介绍了一套针对于低比特量化的 scaling laws。

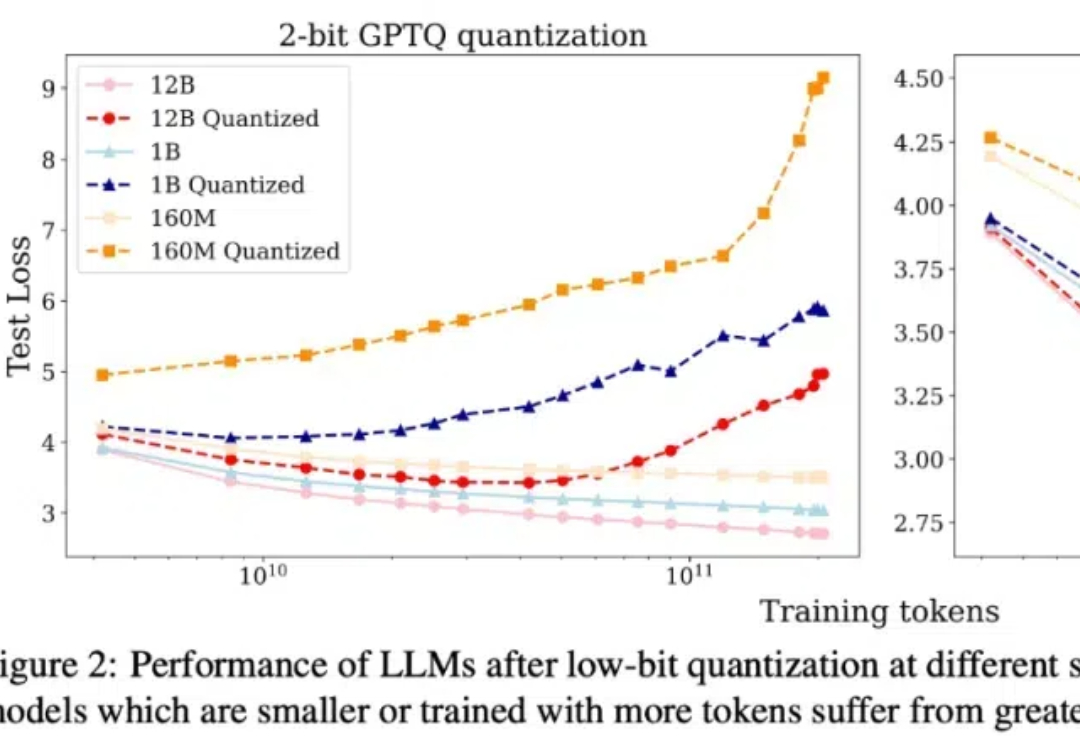

在机器人空间泛化领域,原来也有一套Scaling Law! 来自清华和新加坡国立大学的团队,发现了空间智能的泛化性规律。 在此基础上,他们提出了一套新颖的算法框架——ManiBox,让机器人能够在真实世界中应对多样化的物体位置和复杂的场景布置。

在营销应用赛道也有类似Scaling Law的规则—— 当营销素材工业化生产的时候,不断提升生产效率,就能产生爆款。

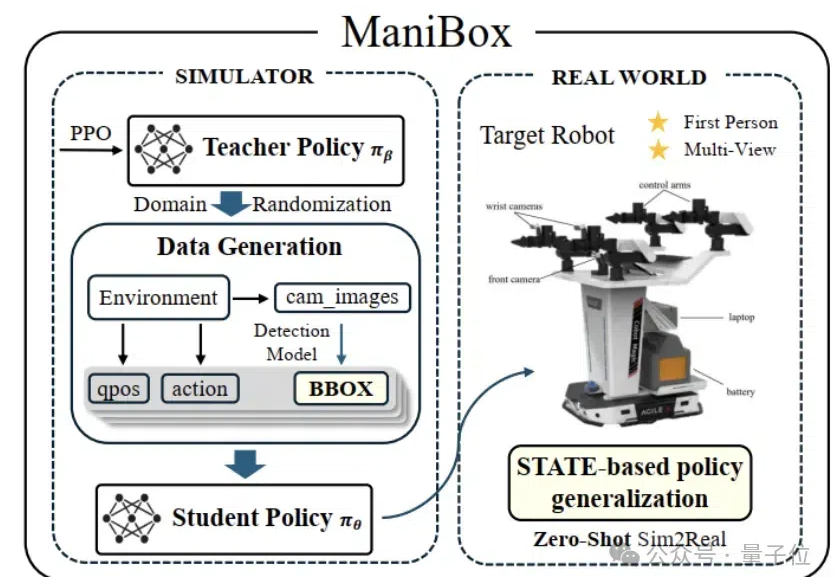

目前关于 RLHF 的 scaling(扩展)潜力研究仍然相对缺乏,尤其是在模型大小、数据组成和推理预算等关键因素上的影响尚未被系统性探索。 针对这一问题,来自清华大学与智谱的研究团队对 RLHF 在 LLM 中的 scaling 性能进行了全面研究,并提出了优化策略。

不像西部世界的 AI 那么智能,现在的 AI 经常没办法满足我的小众需求。 我开始以为是模型能力的问题,但是试用了各家的 AI 发现它们都因为使用的搜索引擎 API 无法搜出相关内容而无法解答。

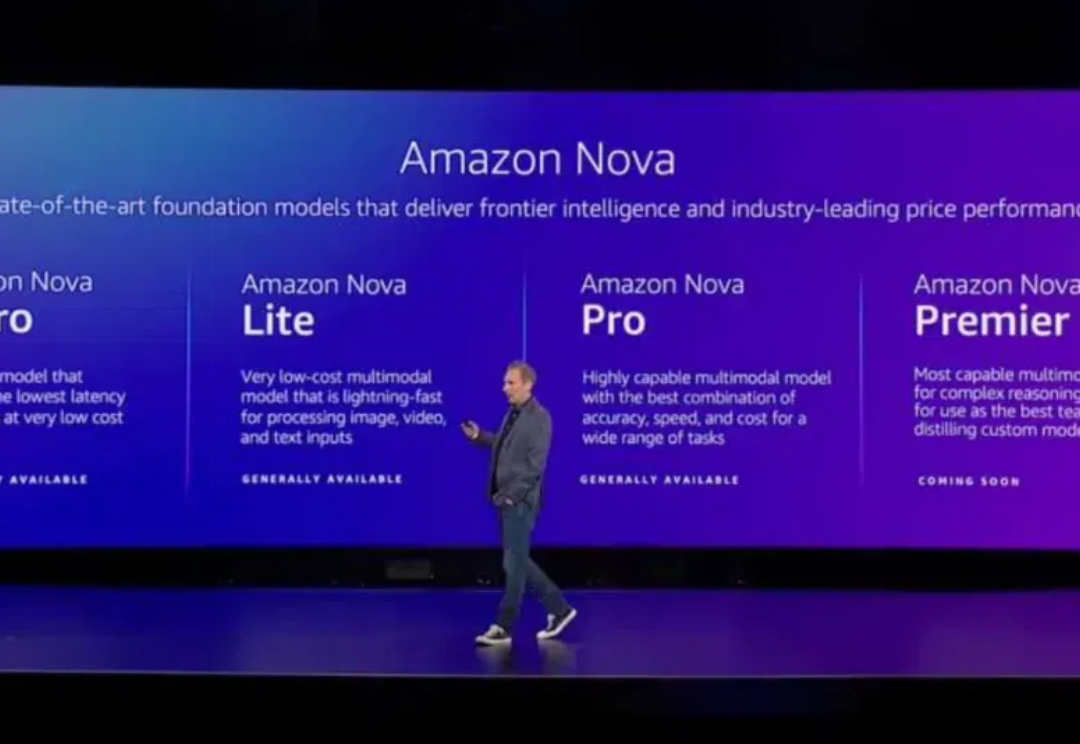

12 月 2-6 日,亚马逊云科技在美国拉斯维加斯举办了今年度的 re:Invent 大会。会上,亚马逊云科技发布了相当多东西,其中之一便是新的大模型系列 Nova。说实话,这确实出乎了相当多人的意料 —— 毕竟亚马逊已经重金押注 Anthropic,似乎没有必要再自起炉灶了。

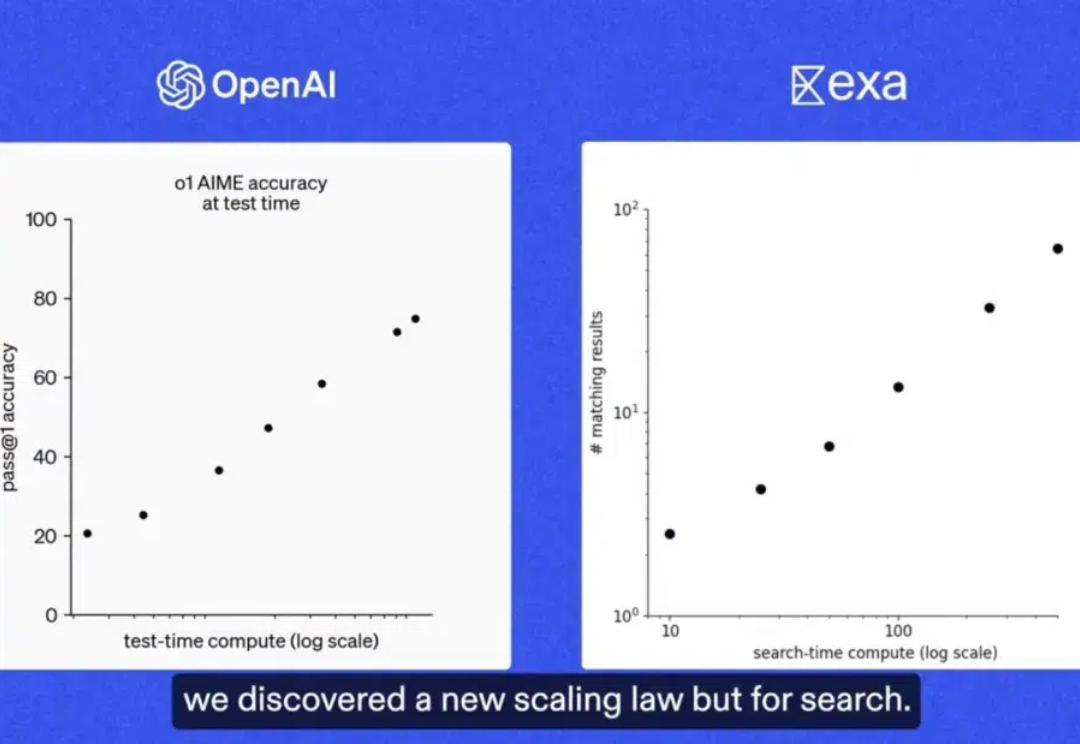

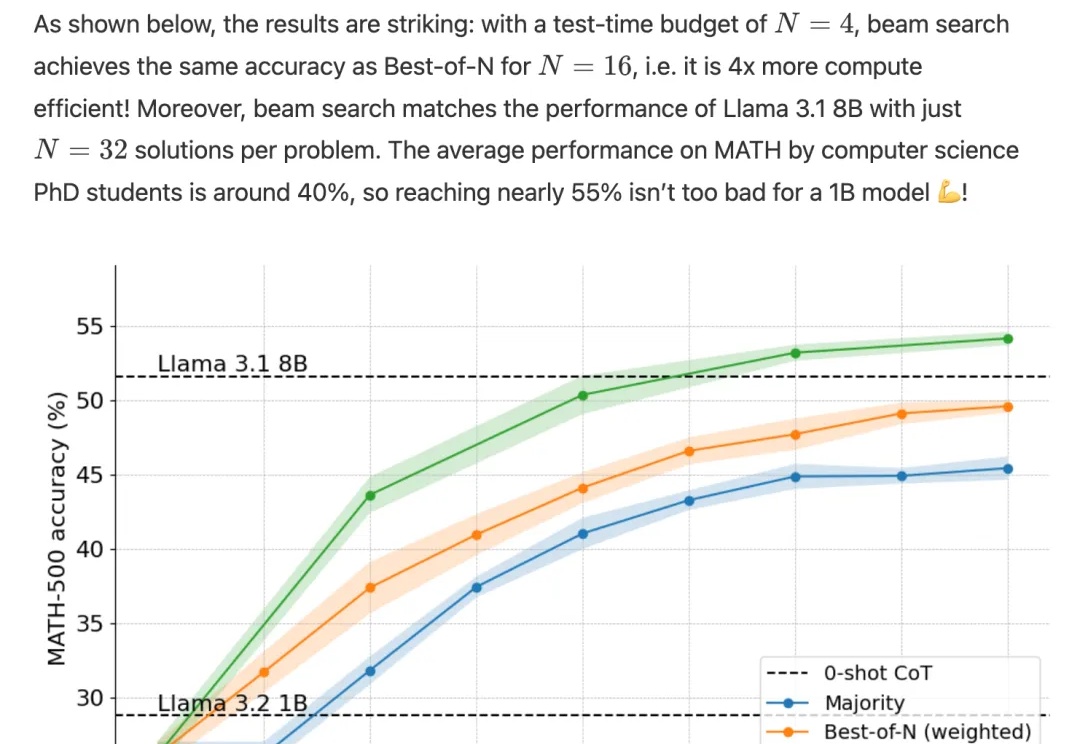

o1完整版公开仅10天,Scaling Law新范式就被逆向工程复现了!

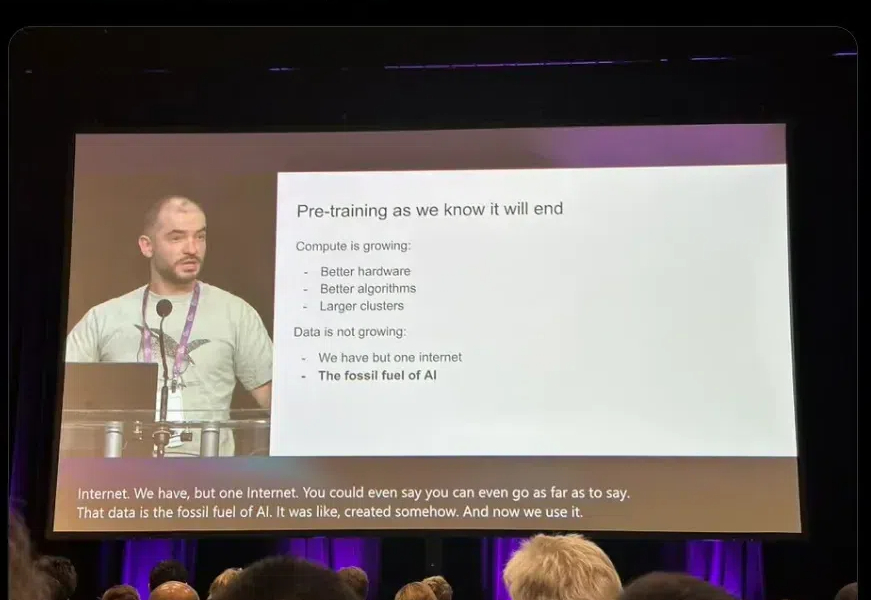

Ilya「预训练结束了」言论一出,圈内哗然。谷歌大佬Logan Klipatrick和LeCun站出来反对说:预训练还没结束!Scaling Law真的崩了吗?Epoch AI发布报告称,我们已经进入「小模型」周期,但下一代依然会更大。

在Ilya探讨完「预训练即将终结」之后,关于Scaling Law的讨论再次引发热议。

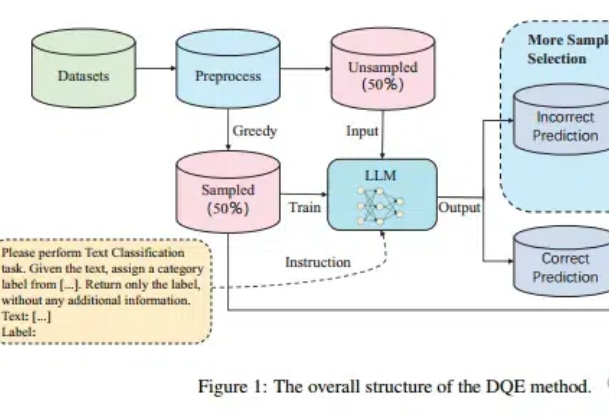

Scaling Law不仅在放缓,而且不一定总是适用! 尤其在文本分类任务中,扩大训练集的数据量可能会带来更严重的数据冲突和数据冗余。